Содержание

АСОЛД и проблемы их использования

Под автономными системами оружия летального действия (далее — АСОЛД) понимается тип автономной военной системы, осуществляющей поиск и поражение цели без значимого контроля со стороны человека на основании заданных пространственно-временных рамок. Автономия присутствует во многих военных приложениях, регулирующих взлёт, посадку и дозаправку военных самолётов, системы предотвращения столкновений с наземным пространством, системы обезвреживания бомб, систем противоракетной обороны и др.

Использование АСОЛД затрагивает правовые, этические и моральные вопросы, которые вызывают озабоченность не только у экспертов и правительств, но и у всего международного сообщества. Большинство государств выступает за запрет АСОЛД в связи с угрозой международной безопасности, другие подчёркивают потенциальную выгоду от того, как будут вестись войны в будущем, и считают любые варианты правового регулирования преждевременными.

В 2017 г. в Женеве Группа правительственных экспертов (ГПЭ) по АСОЛД провела совещание под эгидой Конвенции о конкретных видах обычного оружия (КНО), которое, в свою очередь, основывалось на трех неофициальных совещаниях экспертов, состоявшихся в период с 2014 по 2016 гг. В рамках выступлений ГПЭ было выражено опасение, что АСОЛД может кардинально изменить характер войны. Отмечалось, что АСОЛД будут неэтичными в силу самой своей природы, поскольку в них отсутствует сострадание. Их существование повысит риск тайных операций и преднамеренных нарушений международного гуманитарного права (МГП), которые приведут к эскалации асимметричных боевых действий и безнаказанности в связи с невозможностью установления ответственности. Также была высказана озабоченность по поводу того, что АСОЛД будут генерировать новые риски распространения оружия и могут повлиять на новую гонку вооружений.

Сохранение значимого человеческого контроля над применением силы является этическим императивом, юридической необходимостью и моральным обязательством. С 2013 года правозащитная организация Human Rights Watch и другие неправительственные организации начали кампанию по запрету роботов-убийц, подняв вопрос о применении полностью автономных оружейных систем.

Некоторые государства расценивают АСОЛД как противоречащие основным принципам международного гуманитарного права и призывают незамедлительно разработать юридически обязательный документ, предусматривающий запрет на их применение. Такой запрет охватывал бы разработку, приобретение, торговлю и развёртывание АСОЛД. В качестве первого шага, Группа правительственных экспертов на своей первой сессии подтвердила, что МГП применяется ко всем вооружениям, включая потенциальную разработку и применение автономных систем оружия, ответственность за применение которых по-прежнему возложена на государства.

АСОЛД может привести к изменению парадигмы правил ведения военных действий. Благодаря достижениям в таких видах технологий как распознавание лиц и автономная навигация АСОЛД могут использоваться в различных активах, начиная с танков и кораблей до небольших коммерческих беспилотных летательных аппаратов. Они позволяют развёртывать на поле боя высоколетальные системы, которые нельзя контролировать или отзывать после запуска. В отличие от других видов оружия, АСОЛД также могут быть нацелены на конкретную группу на основе таких параметров как возраст, пол, этническая принадлежность (если такая информация загружена в алгоритм программы).

Поскольку АСОЛД значительно снижают стоимость персонала и могут быть легко получены при низких затратах (как в случае с небольшими беспилотными летательными аппаратами), даже маленькие группы людей могут потенциально нанести непропорциональный вред, что сделает АСОЛД новым классом оружия массового уничтожения. Такой класс смертоносного автономного оружия был бы глубоко дестабилизирующим из-за высокого риска его распространения, поскольку эти системы могут быть созданы любыми государственными или негосударственными субъектами — например, террористическими группировками.

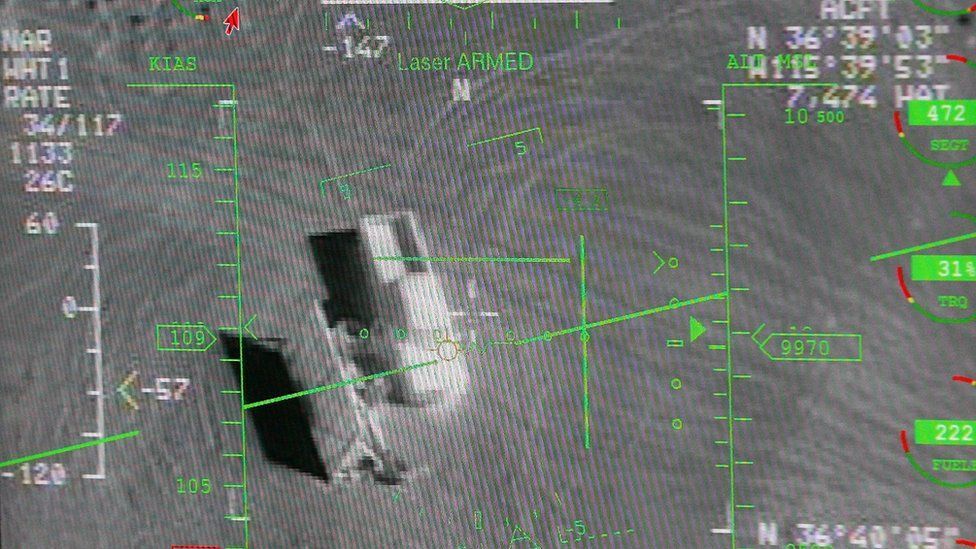

Одним из наиболее известных видов АСОЛД является беспилотный летательный аппарат (БПЛА). Под БПЛА подразумеваются все летательные аппараты, не пилотируемые летчиком, в том числе и те, чей полет заранее запрограммирован на земле и не может быть скорректирован оператором в процессе его выполнения. Дистанционно пилотируемые аппараты могут летать как по заранее введенному в память бортового вычислителя маршруту, так и по корректирующим командам оператора.

Опасения, связанные с применением данного типа специальных средств, оружия и военной техники, подкрепляются последними случаями массовой атаки беспилотных летательных аппаратов неизвестными террористическими группами на военные объекты, находящиеся в Сирии. Другой известный кейс — применение турецкого ударного Bayraktar TB2 в Нагорном Карабахе. Дрон, разработанный компанией Baykar, применялся Турцией и в Сирии во время операции «Весенний щит» в феврале 2020 года. Также он использовался против армии Хафтара в Ливии. А в 2021 году вооружённые силы Украины сообщили о первом боевом применении Bayraktar TB2 в Донбассе. Беспилотник данного типа способен действовать под контролем оператора или автономно, его можно применять в целях разведки, наблюдения или нанесения ударов. В случае последнего он несёт управляемые авиабомбы с лазерным наведением MAM (Mini Akıllı Mühimmat — «Умные мини-боеприпасы») производства компании Roketsan Roket Sanayii ve Ticaret A.S.

По мнению, специалиста в области беспилотных систем Дениса Федутинова, «Недостаточная разрешающая способность бортовой оптикоэлектроники может не позволить достоверно идентифицировать цели. Алгоритмы распознавания образов могут ошибочно классифицировать обнаруженные гражданские объекты как военные».

Тем самым, сложились два основных мнения: некоторые считают, что автономные виды оружия имеют возможность сделать войну более гуманной и уменьшить жертвы среди гражданского населения, будучи более точными при нападении на участников военных действий; другие обеспокоены рисками того, что это оружие попадёт в руки террористов.

Важной задачей в формировании безопасного будущего является обеспечение того, чтобы более мощный искусственный интеллект был безопасным и соответствовал принципам соблюдения прав человека и гуманности.

Роботы-убийцы меняют отношения между людьми и технологиями, передавая принятие решений о сохранении или отнятии жизни машинам. Они бросают вызов человеческому контролю над применением силы. Однако технологии разрабатываются и создаются самими людьми.

Правительства и компании быстро разрабатывают автономные системы вооружения, используя новые технологии и искусственный интеллект. «Роботы-убийцы» могут быть использованы в зонах конфликтов, полицией и пограничным контролем. Но машине не должно быть позволено принимать решение о жизни или смерти человека. Эксперты ООН доложили Совету Безопасности о недавнем применении «летального автономного оружия» в конфликте в Ливии. Применение этих боеприпасов без каких-либо конкретных ограничений на то, как они функционируют или как они применяются, показывает, что необходимость в новом международном договоре является неотложной мерой для ответа современным вызовам.

Международные стандарты

Конкретной нормы, относящейся к автономным системам вооружения, не существует. Однако право гласит, что государства должны выяснять, не запрещено ли международным правом применение какого-либо нового вида оружия либо средства или метода ведения войны, которые оно разрабатывает или приобретает при некоторых или при любых обстоятельствах. Данное требование содержится в Дополнительном протоколе I к Женевским конвенциям от 1977 года. В статье 36 есть механизм, с помощью которого возможно осуществить превентивный запрет АСОЛД. Содержание данной статьи определяет, что при изучении, разработке, приобретении или принятии на вооружение новых видов оружия, средств или методов ведения войны Высокая Договаривающаяся Сторона должна определить, подпадает ли их применение, при некоторых или при всех обстоятельствах, под запрещения, содержащиеся в настоящем Протоколе или в каких-либо других нормах международного права, применяемых к Высокой Договаривающейся Стороне.

В соответствии с международным гуманитарным правом материально-правовые нормы, описанные выше, дополняются процедурной нормой. Как и в случае любого другого оружия, средств или методов ведения войны, государства несут позитивное обязательство определять при изучении, разработке, приобретении или принятии любой автономной системы вооружения, будет ли их применение противоречить существующему международному праву. В этой связи обязанность проводить юридические обзоры, как указано в статье 36 Дополнительного Протокола к Женевским Конвенциям, представляет собой важный элемент в предотвращении или ограничении разработки и применения новых видов оружия, которые не соответствовали бы перечисленным выше обязательствам. Кроме того, адекватные испытания и технические обзоры могут также иметь значение для определения уровня ответственности государств, в том числе за неисправность утверждённых автономных систем вооружения.

Почти 100 государств признали важность человеческого контроля над применением силы. Сотни технологических компаний обязались никогда не участвовать и не поддерживать разработку, производство или использование автономных систем вооружения. Тысячи экспертов по искусственному интеллекту и робототехнике предостерегли от АСОЛД и призвали Организацию Объединенных Наций принять меры. Генеральный секретарь ООН Антониу Гутерриш обозначил опасность автономных систем вооружения:

Существование и использование машин, которые способны самостоятельно выбирать цель и поражать ее, недопустимы с политической точки зрения и отвратительны – с позиции нравственности. Они должны быть запрещены международным правом.

Международный комитет Красного Креста заявил, что для решения проблемы автономных систем вооружения необходим новый закон, и призвал к созданию единого документа, сочетающего запреты и правила.

В случае если мировое сообщество установит норму, согласно которой будет решено отстранить людей от принятия решения о лишении человеческой жизни, и уступить управление оружием автономным алгоритмам, несложно представить себе насколько остро встанут вопросы, связанные с ответственностью человека за разработку подобных алгоритмов. Хотя уже сейчас всё больше полномочий передаются в использование ИИ для упрощения процедур в судебной или медицинской сфере.

Кроме того, существуют значительные социальные, технические и этические риски, связанные с АСОЛД, которые выходят за рамки устранения человеческого контроля над решением о введении алгоритма летального действия. Системы вооружения подобного рода рискуют быть ненадёжными поскольку трудно представить себе какой-либо учебный комплекс, который мог бы хоть немного приспособиться к динамичным и непредсказуемым условиям войны.

Проблема «ненадёжности» усугубляется в будущем, где смертоносные автономные системы оружия противоборствующих сторон взаимодействуют друг с другом. Системы будут намеренно спроектированы так, чтобы вести себя непредсказуемо, чтобы ответить на контрмеры противника.

По мнению Кристофера Хекмана, специалиста в области компьютерных технологий из Колорадского университета, деятельность которого финансирует DARPA (агентство по разработке перспективных вооружений при Минобороны США), единственный реализуемый вариант — саморегулируемые надзорные организации национального уровня, которые будут оценивать все исследования в данной области. В данном случае эксперт не выступает за категоричный и тотальный запрет на разработку роботов-убийц — скорее всего, его точка зрения сводится к обеспечению квалифицированного контроля.

Новое поколение автономных роботов может стать причиной массового уничтожения мирного гражданского населения, предупреждает бывший инженер Google Лора Нолан. В знак своего протеста против военных контрактов, лично ознакомившись с их содержанием, она уволилась из компании. Google предложила Лоре поработать над проектом Maven в 2017 году для армии США — технологией военных дронов, которыми управляет искусственный интеллект. К этому времени она проработала в компании четыре года и стала одним из ведущих программных инженеров Google в Ирландии. Однако Нолан серьезно сомневалась в этичности проекта Министерства обороны США, задача которого состояла в том, чтобы ускорить распознавание изображений для дронов.

Компания была вынуждена закрыть проект Maven, после того как 3000 сотрудников подписали петицию против участия Google в таких разработках. В последующем Лора Нолан присоединилась к кампании по запрету роботов-убийц и проинформировала дипломатов ООН в Нью-Йорке и Женеве об опасностях автономного вооружения.

В соответствии с докладом Генерального секретаря ООН от 2020 г., посвященным теме защиты гражданских лиц во время вооружённых конфликтов, обозначены возможные формы вредоносного использования цифровых технологий, включающих кибератаки, нацеленные на критически важные объекты и инфраструктуру. В частности, активное использование цифровых технологий в таких секторах как здравоохранение и энергетика делает их особенно уязвимыми для целенаправленных кибератак. Так, во время пандемии COVID-19 множество медицинских учреждений в ряде стран подверглось серьезным кибератакам. ВОЗ также столкнулась с огромным количеством кибератак и инцидентов, с участием группы кибермошенников. Аналогичным образом, кибератаки, сказывающиеся на функционировании инфраструктуры электроэнергетики и водоснабжения в условиях вооруженного конфликта, могут причинить значительный ущерб гражданскому населению.

Рост глобальной взаимосвязанности означает, что частота таких атак и масштабы их последствий, возможно, будут расти, затрагивая одновременно множество систем или сетей. Меры, принимаемые в ответ на эти нападения, могут привести к усилению существующей угрозы для гражданского населения. Проблемы, связанные с определением того, кто стоит за кибератаками и каковы намерения этих лиц, усугубляются проблемами, связанными с чётким разграничением государственных и негосударственных субъектов в киберпространстве. Все большее число государств признают, что нормы международного гуманитарного права применимы к операциям в киберпространстве во время вооруженных конфликтов. Несмотря на это, необходимо продолжить обдумывать данную проблему, с тем чтобы выявить способы уменьшения потенциальных людских потерь в результате таких операций и выработать консенсус в отношении толкования норм международного гуманитарного права.

Положение в Казахстане на сегодня

Казахстан, является ответственным и активным сторонником процесса глобального разоружения. Превентивный запрет АСОЛД в полной мере соответствует пункту 6 мер для укрепления режима нераспространения и международной безопасности, предложенных бывшим Председателем Совета Безопасности Республики Казахстан Нурсултаном Назарбаевым. Президент Касым-Жомарт Токаев в своем выступлении на общих дебатах 74-й сессии Генеральной Ассамблеи ООН 24 сентября 2019 года подчеркнул, что растущее число неразрешенных конфликтов и эскалации напряженности связаны с интенсивным соперничеством в сферах цифровых технологий и искусственного интеллекта.

Также в Концепции внешней политики Республики Казахстан на 2020-2030 годы проговаривается «участие [Казахстана] в международных усилиях по предотвращению гонки обычных и новых видов вооружений, поддержка мер по сохранению и продвижению международных режимов контроля над обычными и новыми видами вооружений». В соответствии с Правилами эксплуатации беспилотных летательных аппаратов в воздушном пространстве Республики Казахстан, БПЛА – это воздушное судно, выполняющее полёт без пилота (экипажа) на борту и управляемое в полёте автоматически, оператором с пункта управления или сочетанием указанных способов. Казахстан, как и ряд других государств, таких как Алжир, Аргентина, Австрия, Боливия, Бразилия, Чили, Китай (только использование), Колумбия, Коста-Рика, Куба, Джибути, Эквадор, Сальвадор, Египет, Гана, Гватемала, Ватикан, Ирак, Иордания, Мексика, Марокко, Намибия, Никарагуа, Пакистан, Панама, Перу, Государство Палестина, Уганда, Венесуэла, Зимбабве поддерживает запрет автономных систем оружия летального действия.

Если обратить внимание на подборку внутренних НПА, то они больше говорят о специальных средствах, оружии и военной технике. В Законе «Об органах национальной безопасности Республики Казахстан» в главе о применении сотрудниками и военнослужащими органов национальной безопасности физической силы, специальных средств, оружия и военной техники предусмотрено положение об условиях и пределах применения физической силы, специальных средств, оружия и военной техники для пресечения нарушения воздушного пространства беспилотными летательными аппаратами над территорией объектов органов национальной безопасности Республики Казахстан. Данная поправка была внесена Законом «По вопросам регулирования цифровых технологий» от 25 июня 2020 года, который внёс важные изменения в нормы использования искусственного интеллекта. Также приказом от 31 декабря 2020 года № 706 и.о. министра индустрии и инфраструктурного развития Республики Казахстан утверждены Правила эксплуатации беспилотных летательных аппаратов в воздушном пространстве Республики Казахстан. Изменения, внесенные данным приказом в законодательство, определили нормы по регулированию процесса использования беспилотных летательных аппаратов, в частности внедрение процедур сертификации, установление требований к дистанционной идентификации и определение зон для их использования. Были также сформулированы правила, ограничивающие режим полетов беспилотников:

1) во время взлета и посадки — ближе 50 метров по горизонтали от любого человека (за исключением человека, управляющего БПЛА), другого транспортного средства, здания или сооружения;

2) во время полета — ближе 100 метров по горизонтали от любого человека (за исключением человека, управляющего БПЛА), другого транспортного средства, здания или сооружения;

3) во всех случаях ближе 150 метров по горизонтали от массового скопления людей и (или) транспортных средств;

4) в запретных и опасных для полетов зонах, зонах ограничения полетов (за исключением полетов в интересах лиц, устанавливающих такие зоны).

Кроме того утвержден Реестр учёта беспилотного летательного аппарата (информация о беспилотном летательном аппарате на дату учёта).

Выводы

- Существует необходимость в разработке и принятии юридически обязывающего международного инструмента по превентивному запрету автономных систем оружия летального действия. Проблема охватывает большое количество дискуссионных вопросов. Результатов будет сложно добиться, так как потребуется достижение консенсуса всех государств и универсальный подход. Универсальный юридически обязательный документ мог бы быть разработан в форме нового протокола к Конвенции об обычном оружии (далее — КНО), в котором этот вопрос обсуждается с 2014 года, либо может быть запрещён договором, заключенным в рамках инициатив, которые успешно запретили противопехотные наземные мины в 1997 году и кассетные бомбы в 2008 году.

- Отсутствие человеческого контроля означает, что пользователи оружия не полностью вовлечены в последствия своих действий. Будь то на поле боя или на протесте, машины не могут сделать сложный этический выбор, не могут понять ценность человеческой жизни. Тем самым можно сделать вывод, что автономная система может нарушить принцип разграничения из-за непонимания контекста и/или последствий. Понимание — это человеческая способность, и без этого понимания теряется сущность моральной ответственности и подрываются существующие правовые нормы.

- Даже простые автономные системы представляют проблему. Согласно Женевским Конвенциям, военные командиры должны уметь судить о необходимости и соразмерности нападения и проводить различие между гражданскими лицами и законными военными целями. Это означает не только понимание системы оружия, но и понимание контекста, в котором оно может быть использовано. В более широкой области или в более длительный период времени «контекст» становится все более сложным — ситуация становится все более и более непредсказуемой. Необходимы новые правовые нормы, чтобы ограничить эту непредсказуемость и обеспечить значимый человеческий контроль.

- Пробелы правового регулирования при весьма интенсивном развитии военных технологий искусственного интеллекта ставят под угрозу возможность обеспечения международного мира и безопасности, а также могут повлечь потерю человеком контроля за применением силы. Легкость в использовании подобных технологий может стать одним из факторов, который позволит поддерживать заинтересованным сторонам состояние войны на отдельных территориях. Указанные обстоятельства подтверждают востребованность четкого международно-правового регулирования данных систем вооружения.

Рекомендации

- Ответственность за разработку, развертывание и использование любой новой системы вооружения в рамках КНО должна обеспечиваться в соответствии с применимым международным правом, в том числе посредством функционирования таких систем в рамках ответственной цепочки командования и контроля со стороны человека.

- Следует укреплять дальнейшее продвижение стратегических инициатив Республики Казахстан в сферах укрепления международной безопасности, в частности усиление контроля над созданием и распространением новых видов оружия.

- Актуально также создание международно-правового инструмента, запрещающего создание, испытание и разработку автономных систем оружия летального действия.

- Оценка рисков и меры смягчения последствий должны быть неотъемлемой частью проектирования, разработки, тестирования и развертывания новых технологий в любых системах вооружения.

- При принятии решений должны быть учтены такие компоненты как: человек-оператор должен иметь представление о том, как функционирует система; понимание операционной среды; и достаточное время для обсуждения.

- Государствам следует принять мандат на проведение в срочном порядке переговоров по юридически обязательному документу на основе рамок, подробно описанных выше. Государства должны продемонстрировать, что КНО остается надлежащим документом для достижения регулирования автономных оружейных систем.

Photo from Getty Images